Apple retarde les nouvelles fonctionnalités de sécurité des enfants suite au scandale de la numérisation de photos

Justin Duino

Apple a récemment annoncé une tonne de fonctionnalités de sécurité pour les enfants pour iOS 15, y compris un outil qui vérifie automatiquement votre iPhone pour le matériel d’abus sexuel d’enfants (ou CSAM). De tels outils sont couramment utilisés dans les services de stockage et de messagerie en nuage, mais la pression d’Apple pour l’analyse sur l’appareil a entraîné un recul majeur sur les réseaux sociaux et dans la presse. En conséquence, Apple retardera toutes ses nouvelles fonctionnalités de sécurité pour les enfants.

Dans une déclaration à 9to5Mac, Apple déclare qu’il a "décidé de prendre plus de temps au cours des prochains mois pour recueillir des commentaires et apporter des améliorations" à ses nouvelles fonctionnalités de sécurité pour les enfants, à savoir le scanner CSAM. Il reconnaît que "les commentaires des clients, des groupes de défense, des chercheurs et autres» a conduit à ce changement de plans.

Pourtant, Apple affirme que son système d’analyse CSAM "est conçu en tenant compte de la confidentialité des utilisateurs". Avant que vos photos ne soient stockées dans iCloud, votre iPhone essaie de les comparer à une base de données de hachages CSAM fournie par le NCMEC et d’autres organisations de sécurité des enfants. Les images correspondantes sont ensuite stockées dans iCloud avec un "bon de sécurité", essentiellement un drapeau invisible que seul Apple peut suivre.

Si votre compte iCloud contient plusieurs images correspondant à CSAM, Apple examinera ces images manuellement. Les images d’abus pédosexuels confirmés sont ensuite signalées au NCMEC. Apple affirme que ce système est plus sécurisé que les technologies de numérisation uniquement dans le cloud, car les images ne sont visibles par l’entreprise que si elles sont signalées avant de quitter votre iPhone.

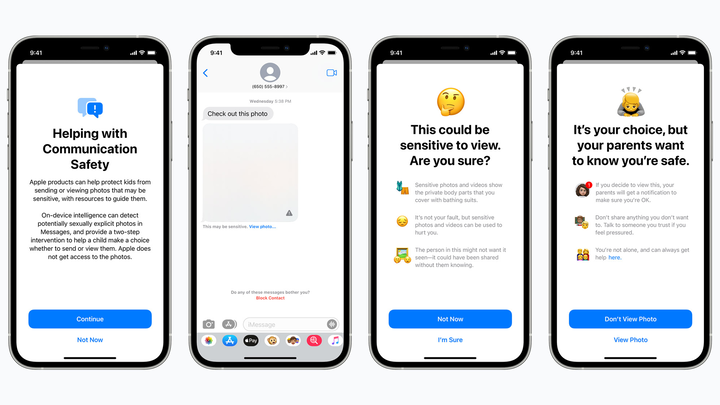

Une fonction de sécurité des enfants prévue masque les images potentiellement sexuellement explicites des enfants dans iMessage et alerte les parents si de telles images sont ouvertes. Pomme

Mais les défenseurs de la vie privée craignent que le scanner CSAM d’Apple détecte les faux positifs, exposant potentiellement des images privées à des étrangers ou ouvrant une porte dérobée aux gouvernements et aux mauvais acteurs. La technologie pourrait également créer un mauvais précédent pour l’avenir – Apple analysera-t-il les téléphones à la recherche de drogues ou d’autres sujets susceptibles d’intéresser les forces de l’ordre ?

On ne sait toujours pas comment Apple compte «améliorer» son scanner CSAM. Mais pour être honnête, la société ne s’attendait probablement pas à voir un contrecoup en premier lieu. De grands noms comme Google utilisent déjà la technologie CSAM dans leurs services cloud et de messagerie, et Apple recherche lui-même le CSAM dans iCloud Mail.

Peu importe où vous vous situez, il est décevant de voir Apple repousser certains de ses nouveaux outils de sécurité pour les enfants, y compris une fonction Messages qui avertit les enfants de ne pas ouvrir de pièces jointes photo ou vidéo potentiellement explicites (cela n’empêche pas les enfants d’ouvrir de telles pièces jointes, mais alerte les parents s’ils le font). Peut-être que ces fonctionnalités arriveront avec des améliorations de la confidentialité quelques mois après iOS 15, mais encore une fois, les plans d’Apple sont très flous.