Apple försenar nya barnsäkerhetsfunktioner efter fotoskanningsskandal

Justin Duino

Apple tillkännagav nyligen massor av barnsäkerhetsfunktioner för iOS 15, inklusive ett verktyg som automatiskt kontrollerar din iPhone efter material om sexuella övergrepp mot barn (eller CSAM). Sådana verktyg används ofta i molnlagring och meddelandetjänster, men Apples satsning på skanning på enheten ledde till stora tryck tillbaka på sociala medier och i pressen. Som ett resultat kommer Apple att fördröja alla sina nya barnsäkerhetsfunktioner.

I ett uttalande till 9to5Mac säger Apple att man har "beslutat att ta ytterligare tid under de kommande månaderna för att samla in input och göra förbättringar" för sina nya barnsäkerhetsfunktioner, nämligen CSAM-skannern. Man erkänner att "feedback från kunder, opinionsbildningsgrupper, forskare och andra" ledde till denna förändring av planerna.

Ändå hävdar Apple att dess CSAM-skanningssystem "är utformat med användarens integritet i åtanke." Innan dina bilder lagras i iCloud försöker din iPhone matcha dem mot en databas med CSAM-hashar från NCMEC och andra barnsäkerhetsorganisationer. Matchade bilder lagras sedan i iCloud med en "säkerhetskupong", i princip en osynlig flagga som bara Apple kan spåra.

Om ditt iCloud-konto innehåller flera CSAM-matchade bilder, kommer Apple att granska dessa bilder manuellt. Bekräftade bilder av sexuella övergrepp mot barn rapporteras sedan till NCMEC. Apple säger att detta system är säkrare än molnbaserad skanningsteknik, eftersom bilder endast är synliga för företaget om de flaggas innan de lämnar din iPhone.

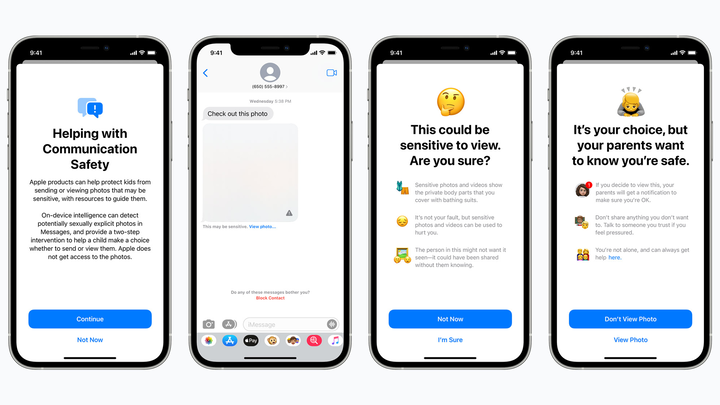

En planerad barnsäkerhetsfunktion döljer potentiellt sexuellt explicita bilder från barn i iMessage och varnar föräldrar om sådana bilder öppnas. Äpple

Men integritetsförespråkare oroar sig för att Apples CSAM-skanner kommer att fånga falskt positiva, potentiellt exponera privata bilder för främlingar eller öppna en bakdörr för regeringar och dåliga aktörer. Tekniken kan också skapa ett dåligt prejudikat för framtiden – kommer Apple att skanna telefoner efter droger eller andra föremål som kan vara av intresse för brottsbekämpande myndigheter?

Vi vet fortfarande inte hur Apple planerar att "förbättra" sin CSAM-skanner. Men om jag ska vara ärlig så förväntade sig företaget förmodligen inte att se någon motreaktion i första hand. Stora namn som Google använder redan CSAM-teknik i sina moln- och meddelandetjänster, och Apple söker själv efter CSAM i iCloud Mail.

Oavsett var du står är det en besvikelse att se Apple trycka tillbaka några av sina nya barnsäkerhetsverktyg, inklusive en meddelandefunktion som varnar barn att inte öppna potentiellt explicita foto- eller videobilagor (det hindrar inte barn från att öppna sådana bilagor, men varnar föräldrar om de gör det). Kanske kommer dessa funktioner med sekretessförbättringar några månader efter iOS 15, men återigen, Apples planer är mycket oklara.