Apple atrasa novos recursos de segurança infantil após escândalo de digitalização de fotos

Justin Duino

A Apple anunciou recentemente vários recursos de segurança infantil para o iOS 15, incluindo uma ferramenta que verifica automaticamente o seu iPhone em busca de material de abuso sexual infantil (ou CSAM). Essas ferramentas são comumente usadas em armazenamento em nuvem e serviços de mensagens, mas a pressão da Apple para a verificação no dispositivo levou a um grande retrocesso nas mídias sociais e na imprensa. Como resultado, a Apple atrasará todos os seus novos recursos de segurança infantil.

Em comunicado ao 9to5Mac, a Apple diz que "decidiu dedicar mais tempo nos próximos meses para coletar informações e fazer melhorias" para seus novos recursos de segurança infantil, ou seja, o scanner CSAM. e outros" levaram a essa mudança de planos.

Ainda assim, a Apple afirma que seu sistema de digitalização CSAM “foi projetado com a privacidade do usuário em mente”. Antes de suas fotos serem armazenadas no iCloud, seu iPhone tenta compará-las com um banco de dados de hashes CSAM fornecido pelo NCMEC e outras organizações de segurança infantil. As imagens correspondentes são armazenadas no iCloud com um “vale de segurança”, basicamente uma bandeira invisível que apenas a Apple pode rastrear.

Se a sua conta do iCloud contiver várias imagens correspondentes ao CSAM, a Apple revisará essas imagens manualmente. As imagens de abuso sexual infantil confirmadas são então relatadas ao NCMEC. A Apple diz que esse sistema é mais seguro do que as tecnologias de digitalização somente na nuvem, pois as imagens só são visíveis para a empresa se forem sinalizadas antes de sair do iPhone.

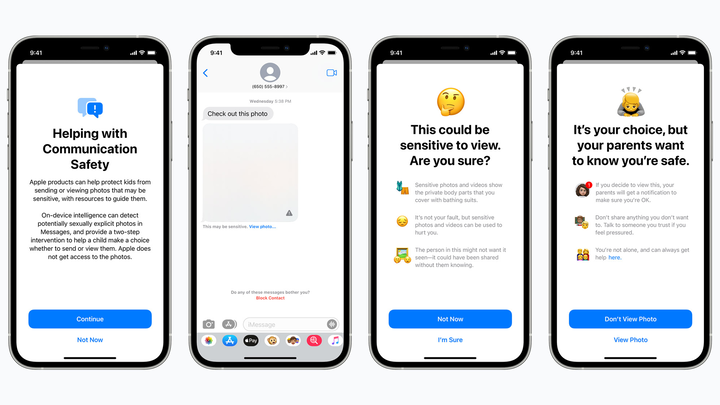

Um recurso de segurança infantil planejado oculta imagens potencialmente sexualmente explícitas de crianças no iMessage e alerta os pais se essas imagens forem abertas. maçã

Mas os defensores da privacidade temem que o scanner CSAM da Apple pegue falsos positivos, potencialmente expondo imagens privadas a estranhos ou abrindo uma porta dos fundos para governos e maus atores. A tecnologia também pode abrir um precedente ruim para o futuro – a Apple irá escanear telefones em busca de drogas ou outros assuntos que possam ser de interesse para a aplicação da lei?

Ainda não sabemos como a Apple planeja “melhorar” seu scanner CSAM. Mas para ser honesto, a empresa provavelmente não esperava ver qualquer reação em primeiro lugar. Grandes nomes como o Google já usam a tecnologia CSAM em seus serviços de nuvem e mensagens, e a própria Apple procura CSAM no iCloud Mail.

Independentemente de onde você esteja, é decepcionante ver a Apple adiar algumas de suas novas ferramentas de segurança infantil, incluindo um recurso de mensagens que avisa as crianças para não abrir anexos de fotos ou vídeos potencialmente explícitos (isso não impede que as crianças abram esses anexos, mas alerta os pais se o fizerem). Talvez esses recursos cheguem com melhorias de privacidade alguns meses após o iOS 15, mas, novamente, os planos da Apple não são muito claros.