Apple відкладає нові функції безпеки дітей після скандалу зі скануванням фотографій

Джастін Дуйно

Apple нещодавно анонсувала безліч функцій безпеки дітей для iOS 15, включаючи інструмент, який автоматично перевіряє ваш iPhone на наявність матеріалів сексуального насильства над дітьми (або CSAM). Такі інструменти зазвичай використовуються в хмарних сховищах і службах обміну повідомленнями, але поштовх Apple до сканування на пристрої призвів до серйозного відштовхування в соціальних мережах і в пресі. В результаті Apple відкладе всі свої нові функції безпеки дітей.

У заяві для 9to5Mac Apple каже, що «вирішила витратити додатковий час у найближчі місяці для збору інформації та вдосконалення» своїх нових функцій безпеки дітей, а саме сканера CSAM. У ньому визнається, що «відгуки клієнтів, адвокатських груп, дослідників та інші» призвело до такої зміни планів.

Проте Apple стверджує, що її система сканування CSAM «розроблена з урахуванням конфіденційності користувачів». Перш ніж ваші фотографії будуть збережені в iCloud, ваш iPhone намагається зіставити їх із базою даних хешів CSAM, наданою NCMEC та іншими організаціями з безпеки дітей. Збігаються зображення потім зберігаються в iCloud з «ваучером безпеки», по суті, невидимим прапорцем, який може відстежувати лише Apple.

Якщо ваш обліковий запис iCloud містить кілька зображень, що відповідають CSAM, Apple перегляне ці зображення вручну. Підтверджені зображення сексуального насильства над дітьми потім повідомляються в NCMEC. Apple каже, що ця система є більш безпечною, ніж технології сканування лише в хмарі, оскільки зображення відображаються для компанії, лише якщо вони позначені, перш ніж залишити ваш iPhone.

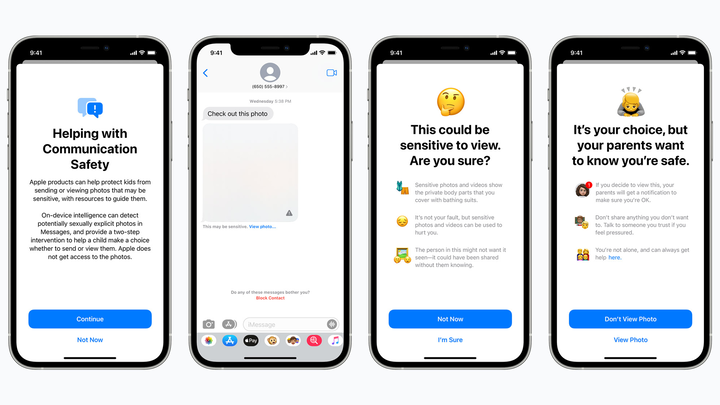

Одна з запланованих функцій безпеки дітей приховує потенційно відверті сексуальні зображення дітей в iMessage і попереджає батьків, якщо такі зображення відкриваються. яблуко

Але прихильники конфіденційності стурбовані тим, що сканер CSAM від Apple буде ловити помилкові результати, потенційно відкриваючи приватні зображення незнайомцям або відкриваючи захід для урядів і поганих акторів. Технологія також може створити поганий прецедент для майбутнього — чи буде Apple сканувати телефони на наявність наркотиків або інших предметів, які можуть бути цікавими для правоохоронних органів?

Ми досі не знаємо, як Apple планує «покращити» свій сканер CSAM. Але, чесно кажучи, компанія, ймовірно, спочатку не очікувала ніякої реакції. Такі великі імена , як Google, уже використовують технологію CSAM у своїх хмарних сервісах та службах обміну повідомленнями, а сама Apple сканує CSAM в iCloud Mail.

Незалежно від того, де ви знаходитесь, розчаровує те, що Apple відкидає деякі з своїх нових інструментів безпеки дітей, включаючи функцію повідомлень, яка попереджає дітей не відкривати потенційно відверті вкладення з фотографіями або відео (це не заважає дітям відкривати такі вкладення, але сповіщає батьків, якщо вони це роблять). Можливо, ці функції з’являться з покращенням конфіденційності через кілька місяців після iOS 15, але знову ж таки, плани Apple дуже неясні.