Apple откладывает внедрение новых функций безопасности детей после скандала с фотосканированием

Джастин Дуино

Apple недавно анонсировала множество функций безопасности детей для iOS 15, в том числе инструмент, который автоматически проверяет ваш iPhone на наличие материалов о сексуальном насилии над детьми (или CSAM). Такие инструменты обычно используются в облачных хранилищах и службах обмена сообщениями, но стремление Apple к сканированию на устройстве привело к резкому отказу в социальных сетях и в прессе. В результате Apple отложит все свои новые функции безопасности детей.

В заявлении для 9to5Mac Apple сообщает, что «решила потратить дополнительное время в ближайшие месяцы на сбор информации и внесение улучшений» в свои новые функции безопасности детей, а именно сканер CSAM. и другие» привели к изменению планов.

Тем не менее Apple утверждает, что ее система сканирования CSAM «разработана с учетом конфиденциальности пользователей». Прежде чем ваши фотографии будут сохранены в iCloud, ваш iPhone пытается сопоставить их с базой данных хэшей CSAM, предоставленной NCMEC и другими организациями по защите детей. Совпадающие изображения затем сохраняются в iCloud с «ваучером безопасности», по сути, невидимым флагом, который может отслеживать только Apple.

Если ваша учетная запись iCloud содержит несколько изображений, соответствующих CSAM, Apple проверит эти изображения вручную. Подтвержденные изображения сексуального насилия над детьми затем передаются в NCMEC. Apple заявляет, что эта система более безопасна, чем облачные технологии сканирования, поскольку изображения видны компании только в том случае, если они отмечены флажком перед тем, как покинуть ваш iPhone.

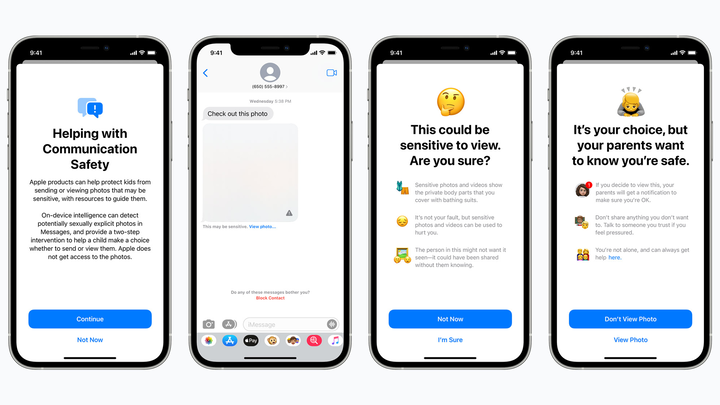

Одна запланированная функция безопасности детей скрывает потенциально откровенно сексуальные изображения от детей в iMessage и предупреждает родителей, если такие изображения открываются. яблоко

Но защитники конфиденциальности опасаются, что сканер Apple CSAM будет обнаруживать ложные срабатывания, что может привести к раскрытию личных изображений незнакомцам или открыть черный ход для правительств и злоумышленников. Эта технология также может стать плохим прецедентом в будущем — будет ли Apple сканировать телефоны на наличие наркотиков или других предметов, которые могут представлять интерес для правоохранительных органов?

Мы до сих пор не знаем, как Apple планирует «улучшить» свой сканер CSAM. Но, если честно, компания, вероятно, не ожидала увидеть какую-либо негативную реакцию. Такие крупные компании, как Google, уже используют технологию CSAM в своих облачных службах и службах обмена сообщениями, а сама Apple сканирует CSAM в iCloud Mail.

Независимо от того, где вы находитесь, разочаровывает то, что Apple отказывается от некоторых своих новых инструментов безопасности детей, включая функцию «Сообщения», которая предупреждает детей, чтобы они не открывали потенциально откровенные вложения с фотографиями или видео (это не мешает детям открывать такие вложения, но предупреждает родителей, если они это делают). Возможно, эти функции появятся с улучшениями конфиденциальности через несколько месяцев после iOS 15, но опять же, планы Apple очень неясны.