Apple verzögert neue Kindersicherheitsfunktionen nach Foto-Scan-Skandal

Justin Duino

Apple hat kürzlich eine Menge Kindersicherheitsfunktionen für iOS 15 angekündigt, darunter ein Tool, das Ihr iPhone automatisch auf Material zum sexuellen Missbrauch von Kindern (oder CSAM) überprüft. Solche Tools werden häufig in Cloud-Speicher- und Messaging-Diensten verwendet, aber Apples Vorstoß zum Scannen auf dem Gerät führte zu einem großen Rückschlag in den sozialen Medien und in der Presse. Infolgedessen wird Apple alle seine neuen Kindersicherheitsfunktionen verzögern.

In einer Erklärung gegenüber 9to5Mac sagt Apple, dass es „beschlossen ist, sich in den kommenden Monaten zusätzliche Zeit zu nehmen, um Input zu sammeln und Verbesserungen vorzunehmen” für seine neuen Kindersicherheitsfunktionen, nämlich den CSAM-Scanner. Es erkennt an, dass „Feedback von Kunden, Interessengruppen, Forschern und andere” führte zu dieser Planänderung.

Dennoch behauptet Apple, dass sein CSAM-Scansystem „unter Berücksichtigung der Privatsphäre der Benutzer entwickelt wurde”. Bevor Ihre Fotos in iCloud gespeichert werden, versucht Ihr iPhone, sie mit einer Datenbank von CSAM-Hashes abzugleichen, die von der NCMEC und anderen Kinderschutzorganisationen bereitgestellt wird. Abgeglichene Bilder werden dann in iCloud mit einem „Sicherheitsgutschein” gespeichert, im Grunde ein unsichtbares Flag, das nur Apple verfolgen kann.

Wenn Ihr iCloud-Konto mehrere CSAM-abgeglichene Bilder enthält, überprüft Apple diese Bilder manuell. Bestätigte Bilder von Kindesmissbrauch werden dann dem NCMEC gemeldet. Laut Apple ist dieses System sicherer als reine Cloud-Scantechnologien, da Bilder für das Unternehmen nur sichtbar sind, wenn sie markiert werden, bevor sie Ihr iPhone verlassen.

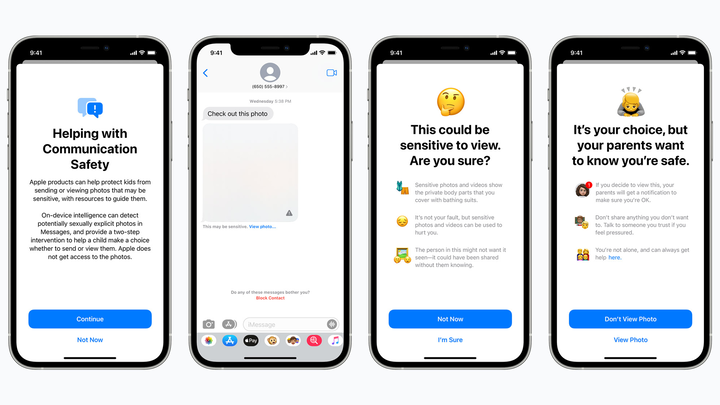

Eine geplante Kindersicherheitsfunktion versteckt potenziell sexuell explizite Bilder von Kindern in iMessage und warnt Eltern, wenn solche Bilder geöffnet werden. Apfel

Aber Befürworter des Datenschutzes befürchten, dass der CSAM-Scanner von Apple Fehlalarme auffängt, möglicherweise private Bilder für Fremde offenlegt oder eine Hintertür für Regierungen und schlechte Akteure öffnet. Die Technologie könnte auch einen schlechten Präzedenzfall für die Zukunft schaffen – wird Apple Handys auf Drogen oder andere Gegenstände scannen, die für die Strafverfolgung von Interesse sein könnten?

Wir wissen immer noch nicht, wie Apple seinen CSAM-Scanner „verbessern” will. Aber um ehrlich zu sein, hat das Unternehmen wahrscheinlich überhaupt nicht mit Gegenreaktionen gerechnet. Große Namen wie Google verwenden die CSAM-Technologie bereits in ihren Cloud- und Messaging-Diensten, und Apple selbst scannt in iCloud Mail nach CSAM.

Unabhängig davon, wo Sie stehen, ist es enttäuschend zu sehen, dass Apple einige seiner neuen Kindersicherheitstools zurückdrängt, einschließlich einer Nachrichtenfunktion, die Kinder davor warnt, potenziell explizite Foto- oder Videoanhänge zu öffnen (sie hindert Kinder nicht daran, solche Anhänge zu öffnen, aber benachrichtigt die Eltern, falls dies der Fall ist). Vielleicht werden diese Funktionen einige Monate nach iOS 15 mit Datenschutzverbesserungen eingeführt, aber auch hier sind die Pläne von Apple sehr unklar.