Apple ritarda le nuove funzionalità di sicurezza dei bambini a seguito dello scandalo della scansione di foto

Giustino Duino

Apple ha recentemente annunciato un sacco di funzionalità per la sicurezza dei bambini per iOS 15, incluso uno strumento che controlla automaticamente il tuo iPhone per materiale pedopornografico (o CSAM). Tali strumenti sono comunemente usati nei servizi di archiviazione cloud e messaggistica, ma la spinta di Apple per la scansione sul dispositivo ha portato a un forte respingimento sui social media e sulla stampa. Di conseguenza, Apple ritarderà tutte le sue nuove funzionalità di sicurezza per i bambini.

In una dichiarazione a 9to5Mac, Apple afferma di aver "deciso di dedicare più tempo nei prossimi mesi per raccogliere input e apportare miglioramenti" per le sue nuove funzionalità di sicurezza dei bambini, vale a dire lo scanner CSAM. Riconosce che "feedback da clienti, gruppi di difesa, ricercatori e altri" ha portato a questo cambio di programma.

Tuttavia, Apple afferma che il suo sistema di scansione CSAM "è progettato pensando alla privacy degli utenti". Prima che le tue foto vengano archiviate in iCloud, il tuo iPhone cerca di confrontarle con un database di hash CSAM fornito da NCMEC e altre organizzazioni per la sicurezza dei bambini. Le immagini abbinate vengono quindi archiviate in iCloud con un "voucher di sicurezza", fondamentalmente una bandiera invisibile che solo Apple può tracciare.

Se il tuo account iCloud contiene diverse immagini corrispondenti a CSAM, Apple esaminerà tali immagini manualmente. Le immagini confermate di abusi sessuali su minori vengono quindi segnalate all’NCMEC. Apple afferma che questo sistema è più sicuro delle tecnologie di scansione solo cloud, poiché le immagini sono visibili all’azienda solo se vengono contrassegnate prima di lasciare il tuo iPhone.

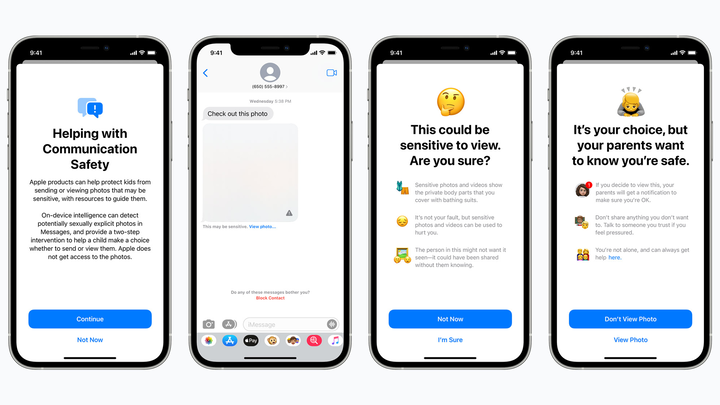

Una funzione pianificata per la sicurezza dei bambini nasconde le immagini potenzialmente sessualmente esplicite dei bambini in iMessage e avvisa i genitori se tali immagini vengono aperte. Mela

Ma i sostenitori della privacy temono che lo scanner CSAM di Apple rilevi falsi positivi, esponendo potenzialmente immagini private a estranei o aprendo una backdoor per governi e cattivi attori. La tecnologia potrebbe anche creare un pessimo precedente per il futuro: Apple eseguirà la scansione dei telefoni alla ricerca di droghe o altri argomenti che potrebbero interessare le forze dell’ordine?

Non sappiamo ancora come Apple intenda "migliorare" il suo scanner CSAM. Ma ad essere onesti, la società probabilmente non si aspettava di vedere alcun contraccolpo in primo luogo. Grandi nomi come Google utilizzano già la tecnologia CSAM nei loro servizi cloud e di messaggistica e la stessa Apple cerca CSAM in iCloud Mail.

Indipendentemente da dove ti trovi, è deludente vedere Apple respingere alcuni dei suoi nuovi strumenti per la sicurezza dei bambini, inclusa una funzione Messaggi che avverte i bambini di non aprire allegati di foto o video potenzialmente espliciti (non impedisce ai bambini di aprire tali allegati, ma avvisa i genitori se lo fanno). Forse queste funzionalità arriveranno con miglioramenti della privacy pochi mesi dopo iOS 15, ma ancora una volta i piani di Apple sono molto poco chiari.